Sfruttando l’aiuto di un modello linguistico avanzato, gli ingegneri del MIT hanno reso possibile ai robot di auto-correggersi dopo errori e proseguire con i loro compiti. Dall’aspirare le macchie al servire il cibo, i robot stanno imparando a svolgere compiti domestici sempre più complessi. Molti di questi apprendisti robotici domestici imparano tramite imitazione; sono programmati per replicare i movimenti che un essere umano li guida fisicamente a compiere.

I robot si sono dimostrati ottimi imitatori. Tuttavia, a meno che gli ingegneri non li istruiscano anche ad adattarsi a ogni possibile urto o spinta, i robot potrebbero trovarsi in difficoltà nel gestire tali situazioni senza dover ricominciare daccapo il loro compito.

Gli ingegneri del MIT stanno ora lavorando per dotare i robot di un minimo di buon senso quando si trovano di fronte a situazioni che li portano fuori dalla loro routine programmata. Hanno sviluppato un metodo che collega i dati sul movimento dei robot con la “conoscenza del buon senso” fornita dai grandi modelli linguistici, o LLM.

Questo approccio consente ai robot di analizzare logicamente i vari compiti domestici e di adattarsi fisicamente alle interruzioni all’interno di un compito, permettendo al robot di proseguire senza dover ricominciare tutto da capo e senza che gli ingegneri debbano programmare correzioni per ogni possibile errore lungo il percorso.

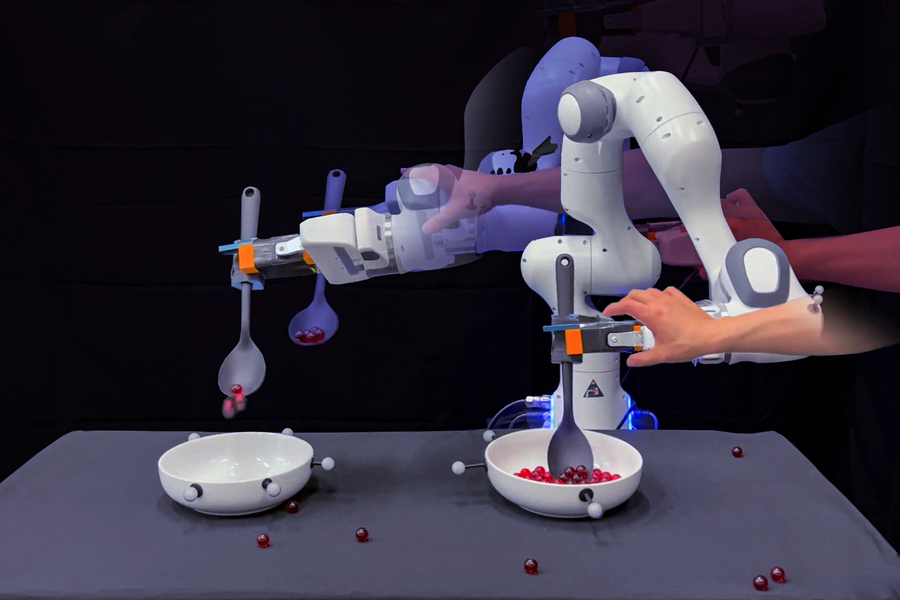

I ricercatori illustrano questo nuovo approccio con un compito molto semplice: raccogliere palline da una ciotola e versarle in un’altra. Di solito, gli ingegneri muovono il robot attraverso questi movimenti in una traiettoria fluida, ripetendo l’azione più volte per dare al robot diverse dimostrazioni da imitare.

“Tuttavia, la dimostrazione umana è una traiettoria continua,” sottolinea Wang.

Il team ha capito che, sebbene un essere umano possa dimostrare un singolo compito in una sola volta, quel compito si compone di una serie di sotto-compiti o traiettorie. Ad esempio, prima che il robot possa raccogliere le palline da una ciotola, deve prima raggiungerla e, successivamente, dovrà trasportarle e versarle in un’altra ciotola. Se il robot dovesse fare un errore durante uno qualsiasi di questi sotto-compiti, la soluzione attuale sarebbe di fermarsi e ricominciare dall’inizio, a meno che gli ingegneri non etichettino esplicitamente ciascun sotto-compito e programmino nuove istruzioni per permettere al robot di recuperare dall’errore.

“Invece, noi e i nostri colleghi abbiamo scoperto che una parte di questo lavoro potrebbe essere automatizzata utilizzando i LLM. Questi modelli di apprendimento profondo elaborano enormi librerie di testo, che utilizzano per stabilire connessioni tra parole, frasi e paragrafi. Attraverso queste connessioni, un LLM può generare nuove frasi basate su ciò che ha appreso sulla probabilità che una parola segua un’altra,” aggiunge Wang.

I ricercatori hanno scoperto che, oltre a generare frasi e paragrafi, un LLM può essere indirizzato a produrre un elenco logico dei sotto-compiti coinvolti in un determinato compito. Ad esempio, se interrogato su quali azioni sono coinvolte nel raccogliere le palline da una ciotola all’altra, un LLM potrebbe produrre una sequenza di verbi come “raggiungere”, “raccogliere”, “trasportare” e “versare”.

“Gli LLM forniscono istruzioni passo-passo in linguaggio naturale per ogni compito. La dimostrazione continua di un essere umano è l’incarnazione di quei passaggi nello spazio fisico,” afferma Wang. “E volevamo collegare questi due aspetti in modo che un robot sapesse automaticamente in quale fase di un compito si trova e potesse ripianificare e recuperare autonomamente.”

This website has quickly become my go-to source for [topic]. The content is consistently top-notch, covering diverse angles with clarity and expertise. I’m constantly recommending it to colleagues and friends. Keep inspiring us!